基于视触融合的机器人抓取滑动检测 -- 崔少伟

基于视触融合的机器人抓取滑动检测 -- 崔少伟

望秋弥茂摘要

- 提出一种基于视触融合的深度神经网络 (VTF-DNN) 感知算法

- 用以检测在机器人抓取和操作过程中发生的抓取物体和夹具之间的滑动现象

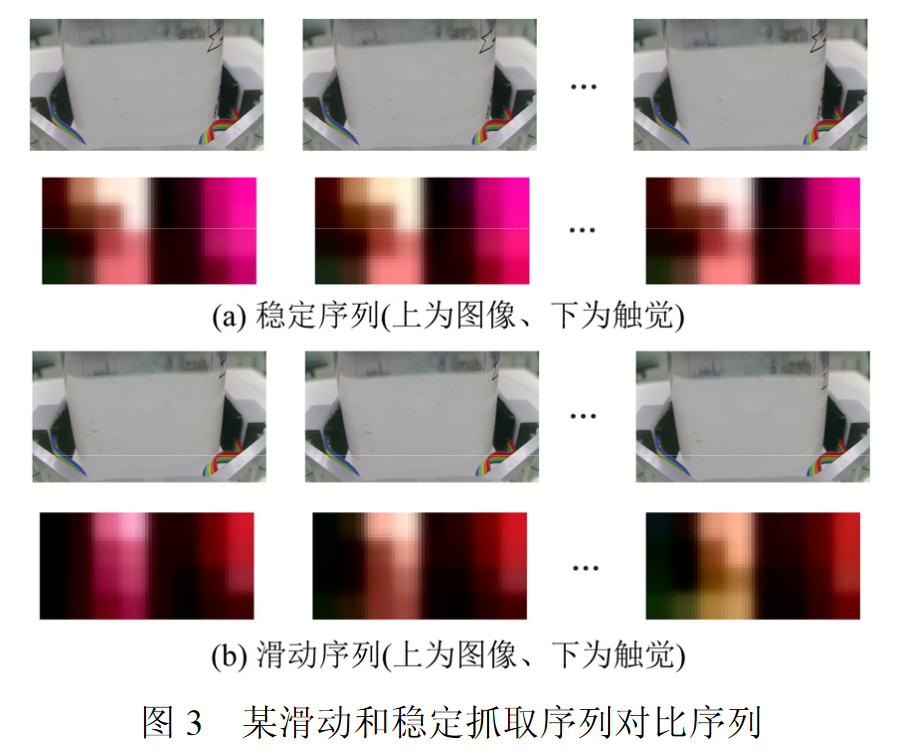

- 不同的抓取位置和力度来抓取不同的物体,收集视觉和触觉序列数据构建视触融合数据集

- 触觉数据:安装在夹具上的阵列触觉传感器采集

- 视觉数据:腕部相机采集

- 某个未参与训练的物体上进行了滑动测试

- 共进行了464次抓取,采集了2320个视觉和触觉序列样本,分类准确度达92.6%

0.背景

- [!] Important:灵巧机器人的应用场景,当抓取力度不足或者抓取策略不当时,机器人抓取操作处于不稳定状态,并通常伴随着滑动现象。滑动检测可以在抓取过程中协助机器人调整抓取力度和策略以保证抓取的稳定性。

- [I] Idea:真实环境中抓取物体较复杂,因此高精度高鲁棒性的滑动检测算法仍然是个值得研究的课题。

- [?] Question:通过检测滑动判断抓取的稳定性及在保证稳定性的前提下尽可能减少抓取力度,从而实现更加灵巧和精确地抓取控制。

- [i] Related Work:

- 文献[8]提出通过感应振动来检测滑动的触觉传感器,可用作灵巧手的指尖。

- 文献[9]测量接触力的法向分量和剪切分量的比值,并将其与表面的摩擦系数进行比较,通过使用力/扭矩来检测平移和旋转滑动.然而此方法须预先测量接触表面的摩擦系数。

- 文献[10]开发出一种热滑微传感器,用于测量接触面的温度变化。当滑动发生时,从传感器到物体的热量流将是触发信号。然而这种热传感器很难区分滑动信号和接触信 号。

- 文献[11]建造了一个具有类人指尖的机器手,配备了视觉和触觉传感器。通过训练具有视觉和触觉数据的神经网络,产生了滑动现象的原始表示。然而此方法无法区分滑动和压力变化,并且也没有展开真正的抓取实验。

- 文献[12]使用 Gelsight 相机触觉传感器检测滑动,用以分析传感器表面触觉信息的 微小变化,准确度达到71%。然而其通过阈值设定的方式来检测滑动涉及到不同对象的大量阈值调整问题。此外,对于具有光滑表面和传感器的接触面积较小的物体,仅通过触觉模态的信息来检测滑动是不准确的。

- 文献[13]通过设置腕部相机来添加额外的视觉模态信息来进行滑动检测,检测准确度达88.03%,所用触觉传感器可直接获取高精度触觉图像,其网络模型不能适用于常见的阵列触觉传感器。直接将视觉和触觉模态的空间特征级联在一起送入循环神经网络的视触融合方式,有可能会损失来自两个模态的时空信息。在滑动检测中,**视觉和触觉两个模态时空信息的融合提取及表示仍然比较困难。

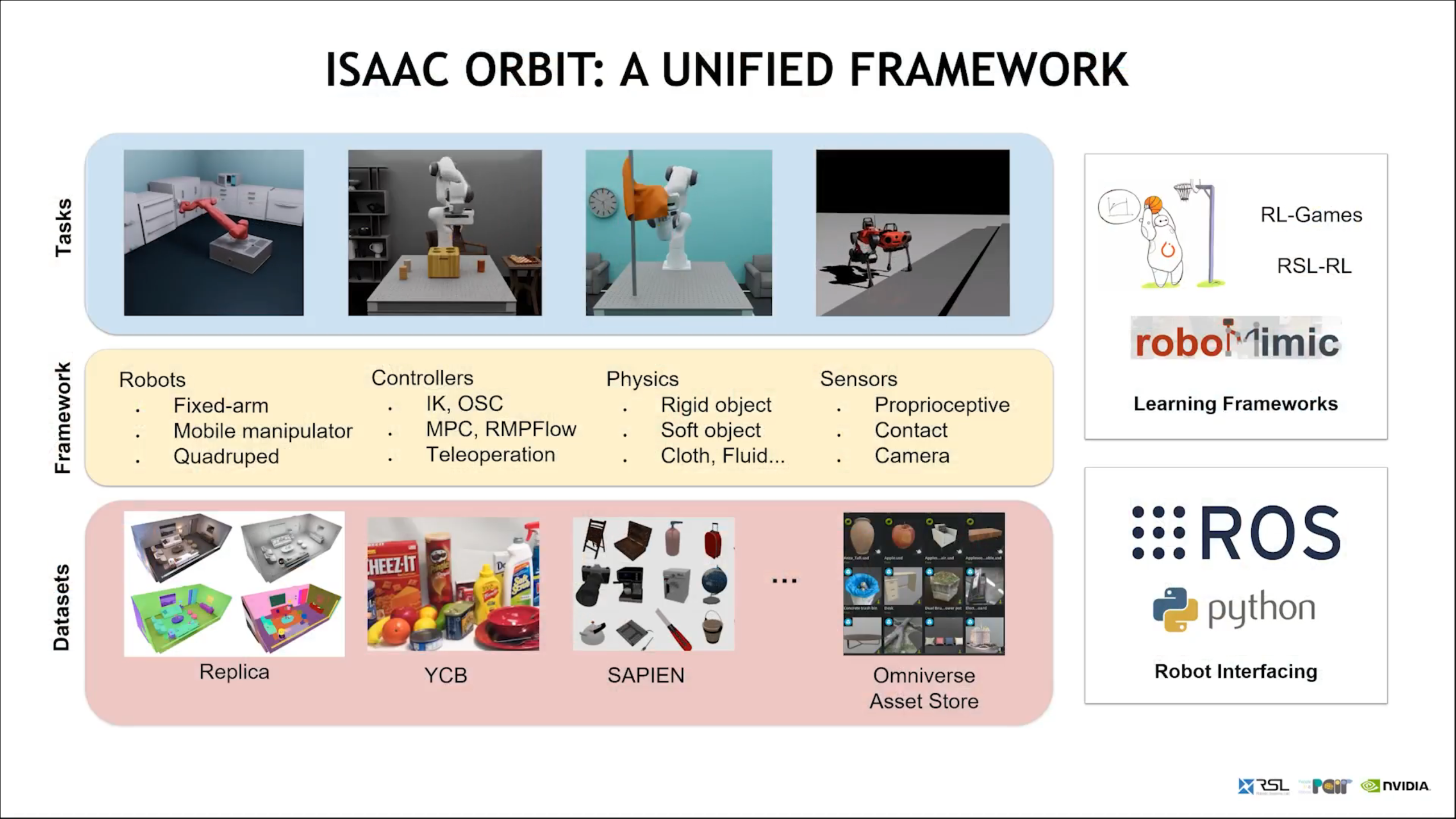

- [p] Methodology:

- 结合视触融合思想,使用普通的阵列触觉传感器及腕部相机提取触觉和视觉模态信息。

- 构建基于卷积长短时记忆循环神经网络 (ConvLSTM)的视触融合深度神经网络模型(VTFDNN)

1.视触融合感知框架结构

1.1问题描述

- 滑动检测任务定义为二分类问题

- 触觉序列:$$(C_0,C_1, …, C_n)$$

- 视觉序列:$$(V_0,V_1, …, V_n)$$

- 神经网络输入:$$F(C_0,C_1, …, C_n;V_0,V_1, …, V_n)$$

- 二分类判断:$$ 分类器输出 =\begin{cases} 滑动状态 & F=0 \ 稳定状态 & F=1 \end{cases}$$

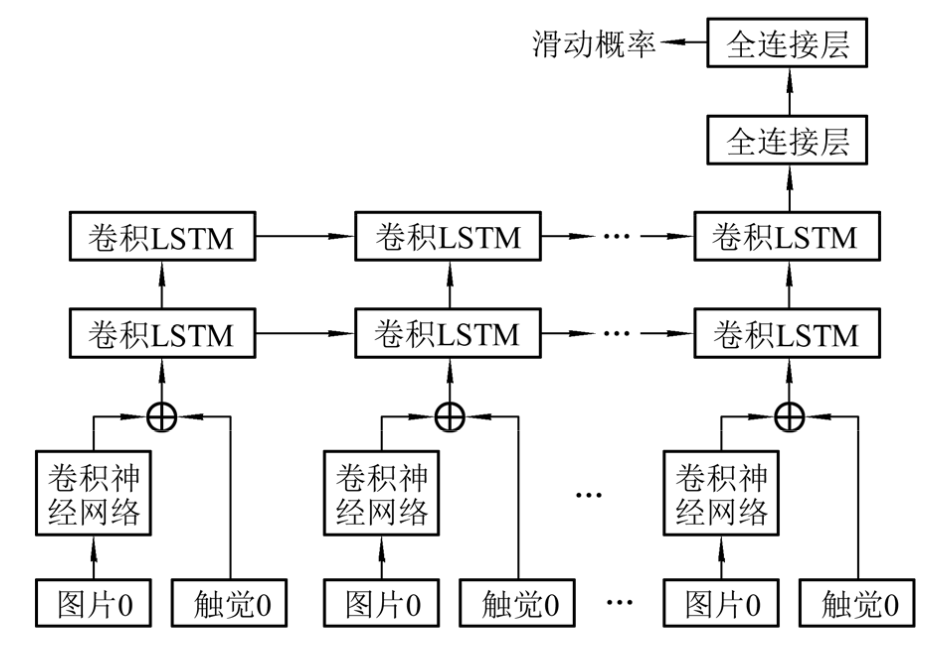

1.2 VTF-DNN 网络结构

网络结构输入:

- 视觉模态:

- 腕部相机获取

- 每帧 视觉图像尺寸为 224×224×3 维度

- 通过预训练好权重VGG-16网络和两个卷积层提取 4×4×64 维度的视觉图像特征图

- CNN的选择:VGG-16,Alex Net,Inception-V3, Resnet 等[15]

- 触觉模态:

- XELA 触觉传感器[14]获取

- 每帧 视觉图像尺寸为 **4×4×3 维度

- 视觉模态:

处理过程:

- 两个模态的数据同时获取

- 时间序列长度为 n+1 帧

- 输出信息为滑动概率

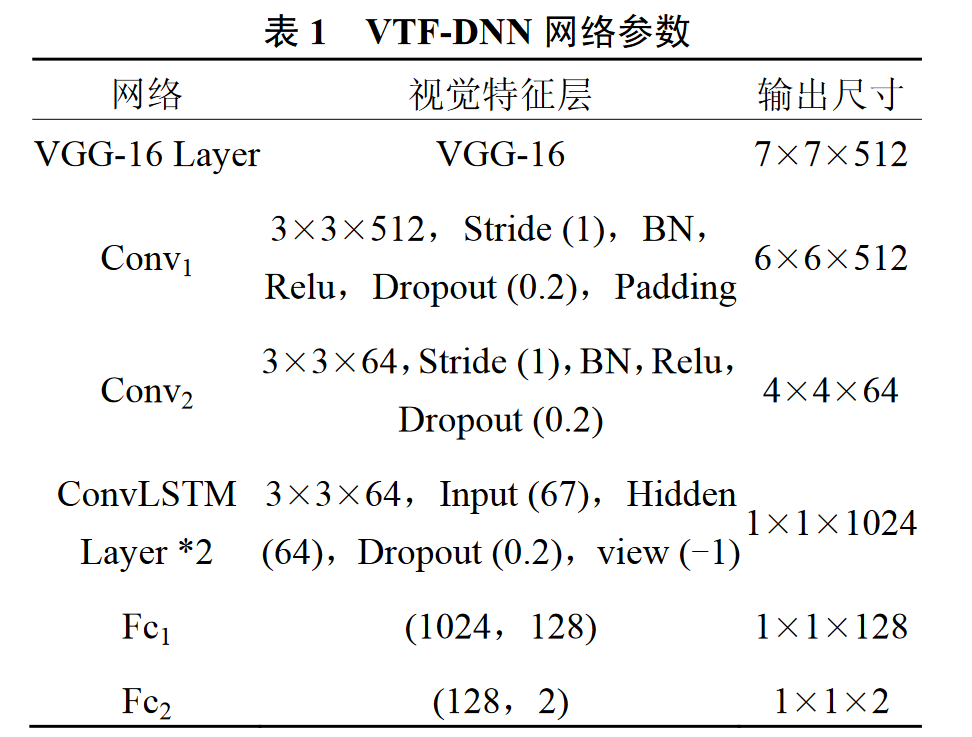

VTF-DNN的网络参数

- $Fc_1$, $Fc_2$ 全连接层输出该时空序列所表示的抓取过程滑动概率

- Xavier 方式初始化网络参数

- 交叉熵作为损失函数

- 采用 Adam 优化器以学习率 $1×10^{-7}$ 进行参数迭代

2.实验结果及分析

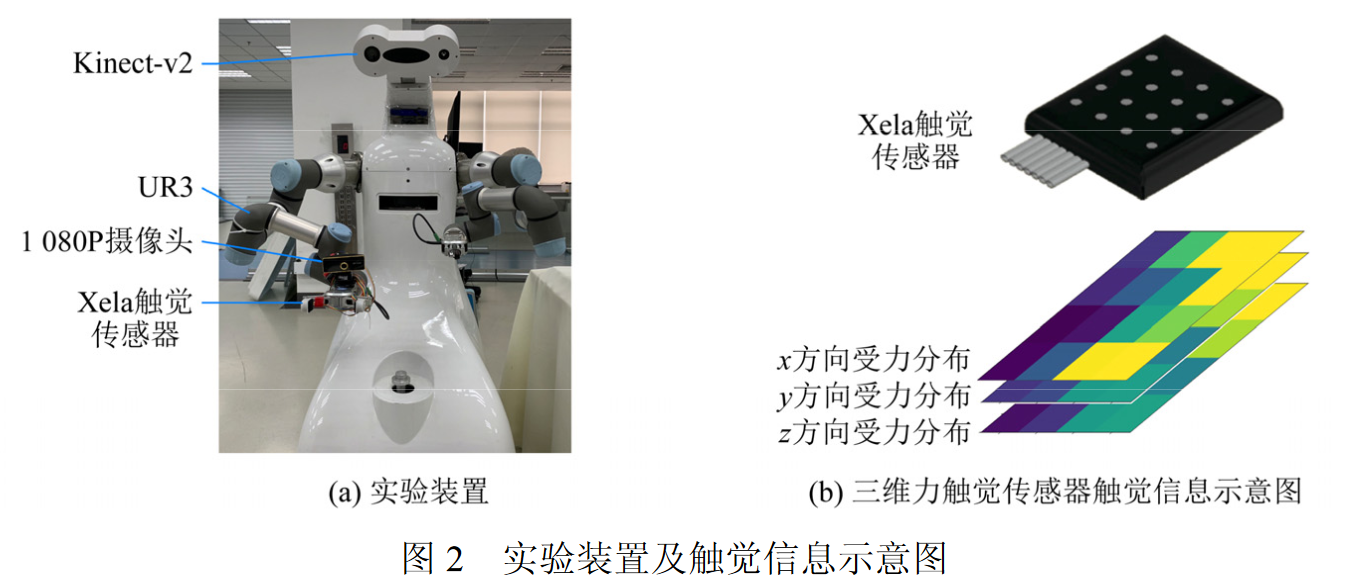

2.1 实验装置及数据采集

实验设备

- UR3 机械臂以及 Onrobot RG2 夹爪

- XELA 触觉阵列传感器通过 3D 打印连接件套装在夹爪末端,4×4 的三维力触觉数据

- 夹爪上侧安装 1080P USB 摄像头记录视觉信息

数据采集

- kinectv2 彩色数据获取抓取目标在视野中的位置

- 深度图得到抓取目标的中心点在 kinectv2 相机坐标系下的位置

- 坐标系转换得到抓取目标在机器臂基坐标系下的位置

- 设置抓取宽度及力度进行抓取以获取对应的滑动和稳定的抓取数据

- 夹爪开始闭合开始以 20 FPS 的速度记录触觉和视觉信息

- 夹爪闭合速度由抓取力度决定,提升高度及速度分别设置为 5 cm 和 20 mm/s

- 每一次抓取中,大约能够收集 40 帧视觉和触觉序列数据

- 滑动检测数据集包含了 10 个日常实验室物品,每个物品进行了约 500 次抓取实验,其中滑动数据大约 200 次,稳定抓取数据大约 300 次

- 为了更好地训练DNN,[13]文献对抓取序列进行5倍扩充。数据增广,总共收集到 $2.1185 ×10^4$个训练集序列及 2320 个测试集序列。

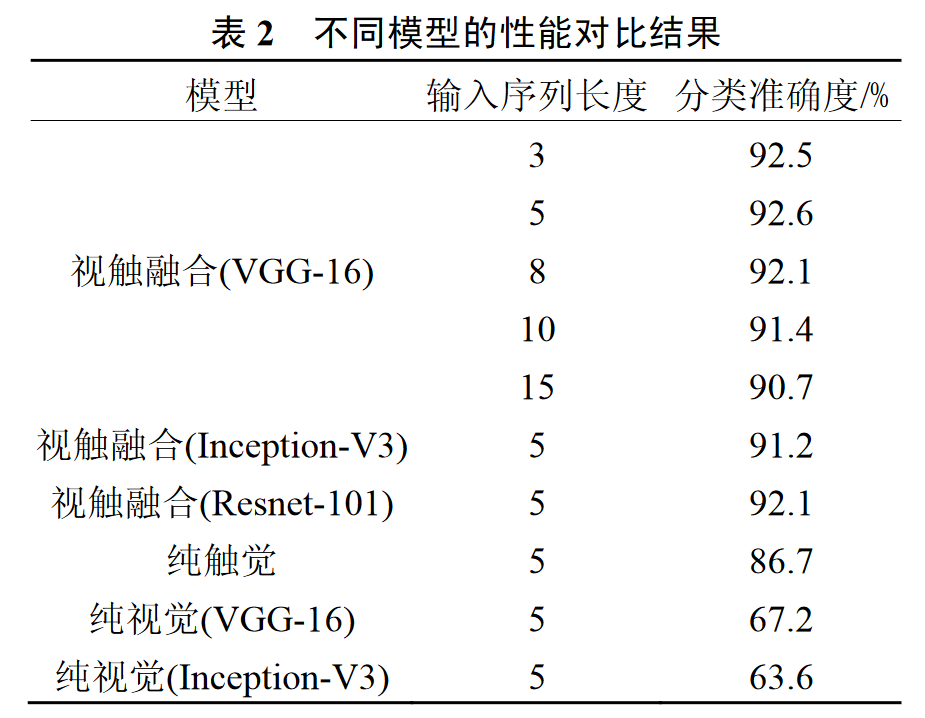

2.2 模型测试结果及分析

- VGG-16,Inception-V3 和 Resnet-101 作为CNN backbone network。

- 对比视触融合、纯视觉和纯触觉三种模态输入。

- 5,10 和 20 Hz 采样率,以及 3,5,8,10 和 15 帧序列长度的模型测试性能。

- 纯视觉模态输入模型采用不同的预训练 CNN 结构添加二分类全连接层作为其网络结构

- 纯触觉模态输入模型采用 Conv LSTM 作为其网络结构。

- 序列长度较短时模型性能较为优异,序列长度为 5 的模型性能要显著优越于序列长度为 15 的模型,20 Hz 采样率的模型分类效果最佳。

- 分别采用 Inception-v3,VGG-16 及 Resnet 作为视觉特征提取结构时,分类模型性能 区别不大,因此采用参数量较小的 VGG-16 作为视觉特征提取结构。

- [?] Question:如何解决长序列的问题???

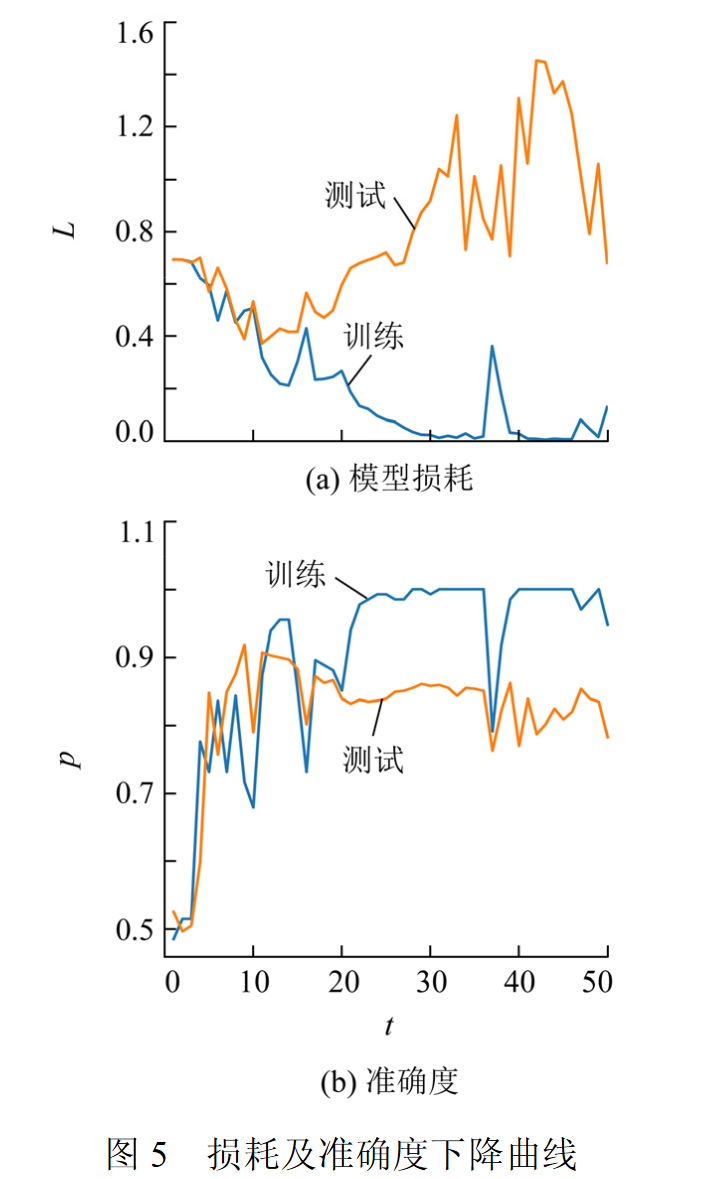

- 当序列为长度为 5 时,损耗及准确度曲线如图 5 所示。

- L 为损耗;p 为准确度;t 为训练迭代次数.

- L 为损耗;p 为准确度;t 为训练迭代次数.

3.结语

- 视触结合,提出用于滑动检测的视触融合深度神经网络框架 VTF-DNN

参考文献

[1] SHIXIANG GU,ETHAN H,TIMOTHY L,et al.Deep reinforcement learning for robotic manipulation with asynchronous off-policy updates[C]// Proc of 2017 IEEE International Conference on Robotics and Automation (ICRA).Singapore:IEEE,2017:3389-3396.

[2] MELCHIORRI C.Slip detection and control using tactile and force sensors[J].IEEE/ASME Transactions on Mechatronics,2000,5(3):235-243.

[3] CHEN W,KHAMIS H,BIRZNIEKS I,et al.Tactile sensors for friction estimation and incipient slip detection—toward dexterous robotic manipulation:a review [J].IEEE Sensors Journal,2018,18(22):9049-9064.

[4] ROMANO J M,HSIAO K,NIEMEYER G,et al. Human-inspired robotic grasp control with tactile sensing [J].IEEE Transactions on Robotics,2011,27(6): 1067-1079.

[5] VEIGA F,VAN HOOF H,PETERS J,et al.Stabilizing novel objects by learning to predict tactile slip[C]// Proc of 2015 IEEE/RSJ International Conference on Intelligent Robots and Systems (IROS).Hamburg:IEEE,2015: 5065-5072.

[6] Peters V J,Hermans T.Grip stabibization of novel objects using ship prediction[J].IEEE Trans Haptics,2018, 11(4):531-542.

[7] FRANCOMANO M T,ACCOTO D,GUGLIELMELLI E.Artificial sense of slip—a review[J].IEEE Sensors Journal,2013,13(7):2489-2498.

[8] COTTON D P J,CHAPPEL P H,CRANNY A,et al.A novel thick-film piezoelectric slip sensor for a prosthetic hand[J].IEEE Sensors Journal,2007,7(5):752-761.

[9] MELCHIORRI C.Slip detection and control using tactile and force sensors[J].IEEE/ASME Transactions on Mechatronics,2000,5(3):235-243.

[10] ACCOTO D,SAHAI R,DAMIANI F,et al.A slip sensor for biorobotic applications using a hot wire anemometry approach[J].Sensors and Actuators A:Physical,2012, 187:201-208.

[11] HOSODA K,YASUNORI T,ASADA M.Internal representation of slip for a soft finger with vision and tactile sensors[C]// Proc of IEEE /RSJ International Conference on Intelligent Robots and Systems.Lausanne: IEEE,2002:111-115.

[12] DONG S Y,YUAN W Z,ADELSON E H.Improved gelsight tactile sensor for measuring geometry and slip [C]// Proc of IEEE/RSJ International Conference on Intelligent Robots and Systems (IROS).Vancouver: IEEE,2017:137-144.

[13] LI J H,DONG S Y,ADELSON E.Slip detection with combined tactile and visual information[C]// Proc of IEEE International Conference on Robotics and Automation (ICRA).Brisbane:IEEE,2018:7772-7777.

[14] TITO P T,SOPHON S,ALEXANDER S,et al. Development of a hall-effect based skin sensor[C]// Proc of IEEE SENSORS.Busan:IEEE,2015:1-4.

[15] ALOYSIUS N,GEETHA M.A review on deep convolutional neural networks[C]// Proc of International Conference on Communication and Signal Processing (ICCSP).Chennai:IEEE,2015:588-592.